안녕하세요. 이번에는 Gemma2 GGUF모델을 로컬Ollama 등록하는 방법을 알려드리겠습니다.

1. Ollama 다운로드 방법

↓ 아래의 링크에 접속을 합니다.

Ollama

Get up and running with large language models.

ollama.com

1-1. 중앙에 있는 [Download↓] 클릭합니다.

1-2. 자신이 사용할 운영체제에 맞추어서 다운로드 를 하면 됩니다.

2. 모델(GGUF) 다운로드 링크 입니다.

https://huggingface.co/sionic/ko-gemma-2-9b-it-Q4_0-GGUF

sionic/ko-gemma-2-9b-it-Q4_0-GGUF · Hugging Face

sionic/ko-gemma-2-9b-it-Q4_0-GGUF This model was converted to GGUF format from rtzr/ko-gemma-2-9b-it using llama.cpp via the ggml.ai's GGUF-my-repo space. Refer to the original model card for more details on the model. Use with llama.cpp Install llama.cpp

huggingface.co

#Huggingface의 오픈모델로 올라와있습니다.

해당 모델은 국내 생성형 AI기업 [사이오닉AI] 기업에서 모델을 학습시키며 양자화를 진행한 모델을 사용하였습니다.

사이오닉 에이아이 - 기업용 AI-Native 솔루션

생성형 AI를 기술적 고민 없이 기업에 바로 적용할 수 있도록 하는 솔루션을 제공합니다. 사이오닉 에이아이와 함께 미래를 대비하고 비즈니스 경쟁력을 확보하세요.

www.sionic.ai

2-1. 페이지에 접속 후 [Files and versions]를 클릭합니다.

2-2. 다운로드 버튼을 클릭해서 다운로드 합니다.

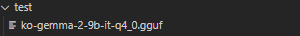

이후 윈도우 같은 경우에는 영문폴더를 생성 후 파일을 넣으면 되겠습니다.

ex) 바탕화면 -> "test" 폴더 생성 -> 다운로드 받은 모델파일을 넣기

3. 사용할 GGUF 모델을 local Ollama에 생성합니다.

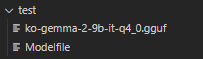

3-1. Modelfile을 생성하기

Modelfile안에는 아래와 같이 작성합니다.

from ko-gemma-2-9b-it-q4_0.gguf

template """

<start_of_turn>user

{{ if .System }}{{ .System }} {{ end }}{{ .Prompt }}<end_of_turn>

<start_of_turn>model

{{ .Response }}<end_of_turn>

"""

parameter stop <start_of_turn>

parameter stop <end_of_turn>

#Gemma2모델은 system 관련해서 지원을 안한다고 하니 system 프롬프트를 제거했습니다.

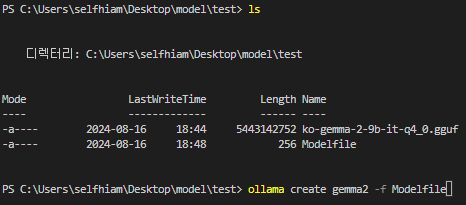

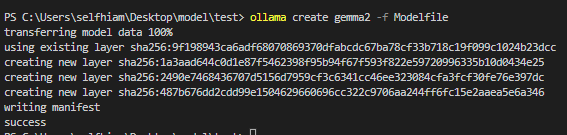

3-2. 명령어를 이용해서 모델 등록

자신이 이전에 넣은 경로로 cd 명령어를 사용해 이동 후 아래의 명령어를 사용하여 ollama에 등록을 합니다.

ollama create gemma2 -f Modelfile

# ollama : 올라마 명령어

# create : 올라마 명령어 - 생성

# gemma2 : 등록할 이름

# -f : 파일지정

# Modelfile : 지정할 파일

위 명령어를 사용할 시 아래와 같은 모습이 보입니다.

# 진행중 표시는 ollama V0.3.6업데이트에서 추가된 내용입니다.

위 퍼센트가 100%가 되면 아래와 같이 success가 나오면 성공입니다.

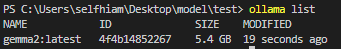

ollama list를 사용하여 등록된 모델을 확인하시면 됩니다.

이렇게 Ollama를 사용해서 모델 등록을 하는방법을 마치겠습니다.

이후에는 vscode와 같이 사용방법, vllm 사용방법 등 많은 내용을 추가하겠습니다.

'AI+RAG' 카테고리의 다른 글

| AI 답변 생성 시스템 구축: LangChain + LangGraph와 Ollama를 사용한 간단한 워크플로우 (0) | 2024.08.19 |

|---|---|

| 로컬 Ollama를 vscode에서 추론을 해보자! (0) | 2024.08.17 |